本周,传神社区继续带来一系列令人兴奋的研究进展,涵盖人工智能、语言模型到大模型应用的多个领域。如果你对下面的任何主题感兴趣,复制链接到浏览器中打开即可,欢迎加入我们的知识旅程,一起探索人工智能的无限可能!

01 SIMA

3D虚拟环境中的通用人工智能代理,在各种广泛的3D虚拟环境和视频游戏中遵循自然语言指令;SIMA接受了600项基本技能的评估,包括导航、对象交互和菜单使用。语言似乎是影响性能的一个重要因素。

论文推荐链接:

https://portal.opencsg.com/daily_papers/7s9MLsPabTDJ

02 检索增强思维(Retrieval Augmented Thoughts)

经研究发现,通过信息检索对思路链进行迭代修订可以显著提升LLM在长期生成任务中的推理和生成能力;关键思想是每个思路步骤都会根据任务查询、当前和过去的思路步骤进行相关信息的修订;可以将检索增强思路(RAT)应用于不同模型,如GPT-4和CodeLlama-7B,以提高长期生成任务(例如创意写作和具体任务规划)的性能;RAT是一种零样本提示方法,并对包括零样本CoT提示、普通RAG和其他基准在内的基准模型提供了显著改进。

论文推荐链接:

https://portal.opencsg.com/daily_papers/P1BWFMW1qwQU

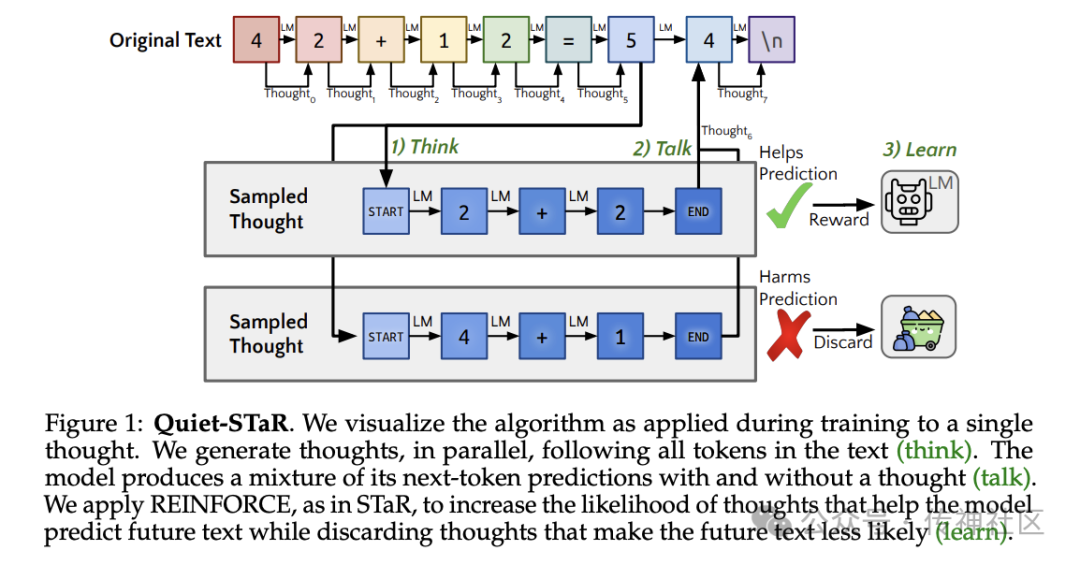

03 LMs Can Teach Themselves to Think Before Speaking

文章提出了STaR的一种泛化,称为Quiet-STaR,以使语言模型(LMs)能够以更一般化和可扩展的方式进行推理学习;Quiet-STaR使LMs能够生成每个标记的原因,以解释未来的文本;它提出了一种逐标记的并行抽样算法,通过高效生成内部思考来改进LM的预测;使用REINFORCE方法改进了原因生成过程。

论文推荐链接:

https://portal.opencsg.com/daily_papers/48Gj2yHhUSBk

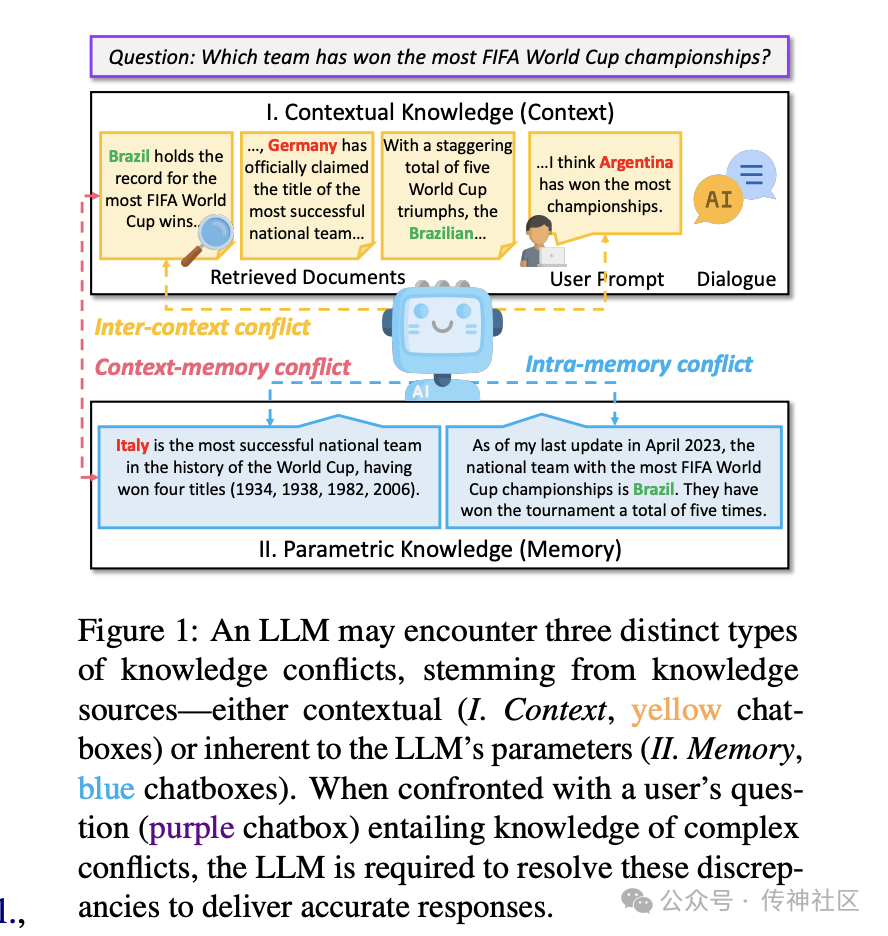

04 Knowledge Conflicts for LLMs

这篇综述论文对LLM工作中常见问题的知识冲突进行了概述,将这些冲突分为上下文记忆、上下文间和内部记忆冲突;它还提供了有关冲突产生原因以及缓解这些知识冲突问题的潜在方法的见解。

论文推荐链接:

https://portal.opencsg.com/daily_papers/hwCYzkzy9yhB

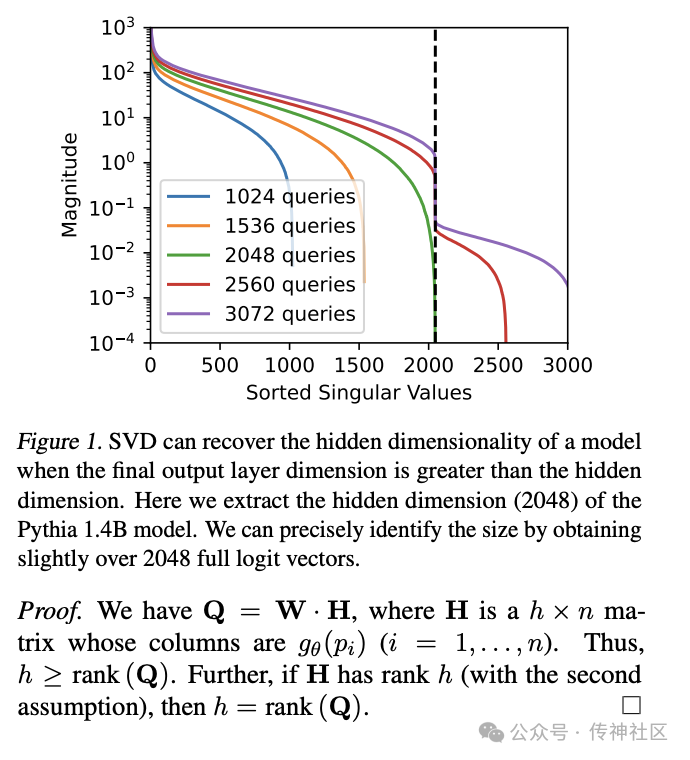

05 Stealing Part of a Production Language Model

文章提出了一种模型窃取攻击方法,可以从ChatGPT或PaLM-2等生产语言模型中提取信息;通过典型的API访问可以恢复基于Transformer的模型的嵌入投影层;以OpenAI的ada和babbage模型为例,整个投影矩阵可以在不到20美元的成本下被提取出来。

论文推荐链接:

https://portal.opencsg.com/daily_papers/Zdt4ygyZbB5U

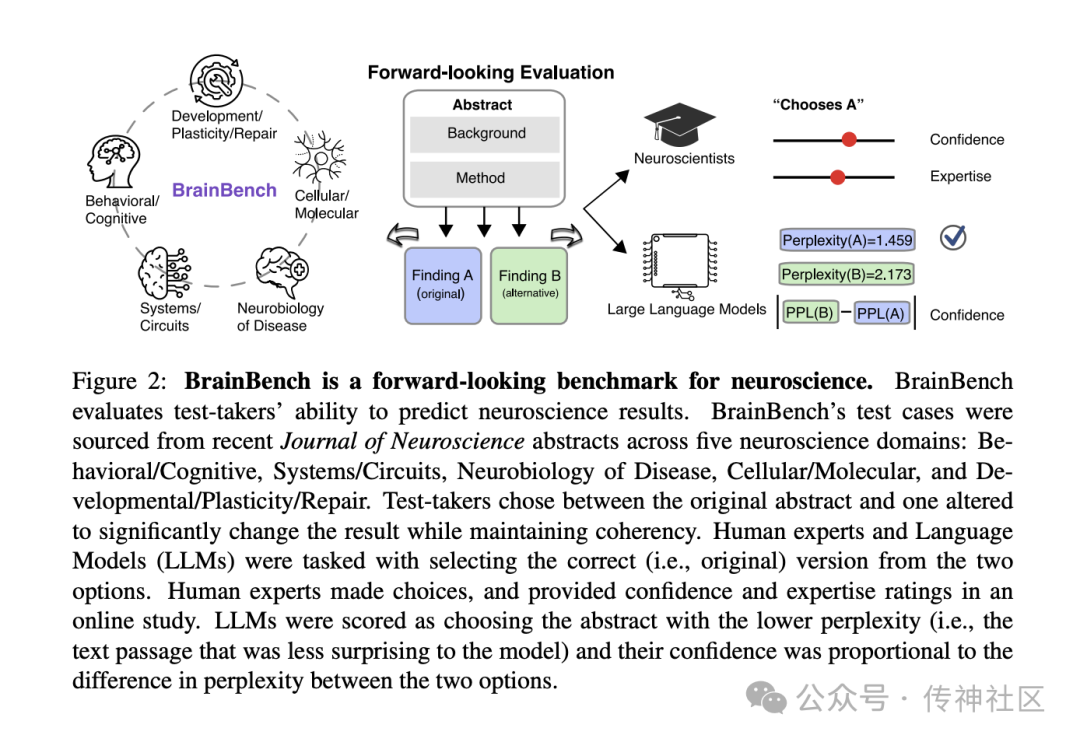

06 LLMs Predict Neuroscience Results

该论文提出了一个评估LLM(Large Language Models,大型语言模型)预测神经科学结果能力的基准测试——BrainBench。研究发现,LLM在预测实验结果方面超过了专家的水平,并且在针对神经科学文献进行调整的LLM的表现甚至更好。

论文推荐链接:

https://portal.opencsg.com/daily_papers/SxLdUwiCCeSN

07 Is Cosine-Similarity Really About Simirity?

该研究探讨了从经过正则化的线性模型中得出的嵌入,并从分析上得出余弦相似性如何产生任意和无意义的相似性的结论;研究还发现,对于某些线性模型,相似性甚至不是唯一的,而其他模型则受到正则化的控制;作者提醒不要盲目使用余弦相似性,并提出了考虑因素和替代方法。

论文推荐链接:

https://portal.opencsg.com/daily_papers/i2sgegVrfu86

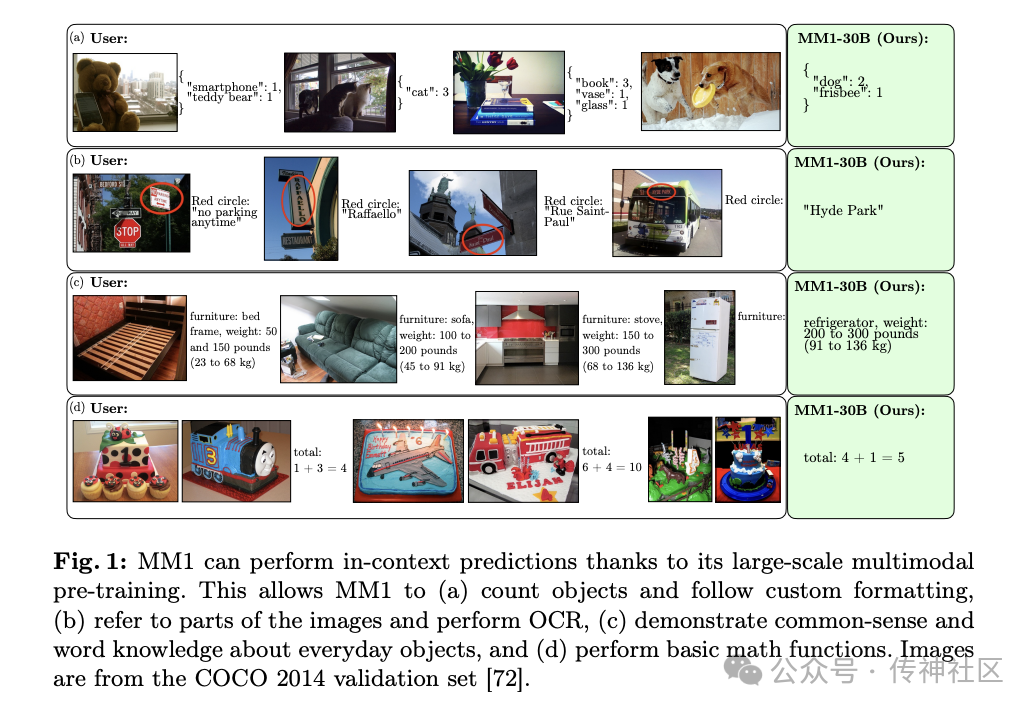

08 Multimodal LLM Pre-training

该论文提供了对多模态LLM预训练方法、分析和见解的全面概述,研究了不同的架构组件,并发现精心混合图像字幕、交错图像文本和仅文本数据对于实现最先进的性能非常关键。该论文还提出了一系列多模态模型,参数规模可达到30B,这些模型在预训练指标上取得了最先进的成果,并具备增强的上下文学习、多图像推理和启用少样本连贯性提示等特性。

论文推荐链接:

https://portal.opencsg.com/daily_papers/vVxyCUdqpmiV

09 Branch-Train-MiX: Mixing Expert LLMs into a Mixture-of-Experts LLM

Sainbayar Sukhbaatar 等人的研究介绍了一种创新的方法,Branch-Train-MiX (BTX),用于在一个模型中融合多个专家LLMs的专业知识。这种方法不仅提高了模型处理特定任务的能力,也在精确度和效率的折衷中取得了显著成绩。对于追求在特定领域内获得更高性能的研究者和工程师而言,BTX 提供了一个高效且有效的解决方案。

论文推荐链接:

https://portal.opencsg.com/daily_papers/ScQqTTtXhCUm

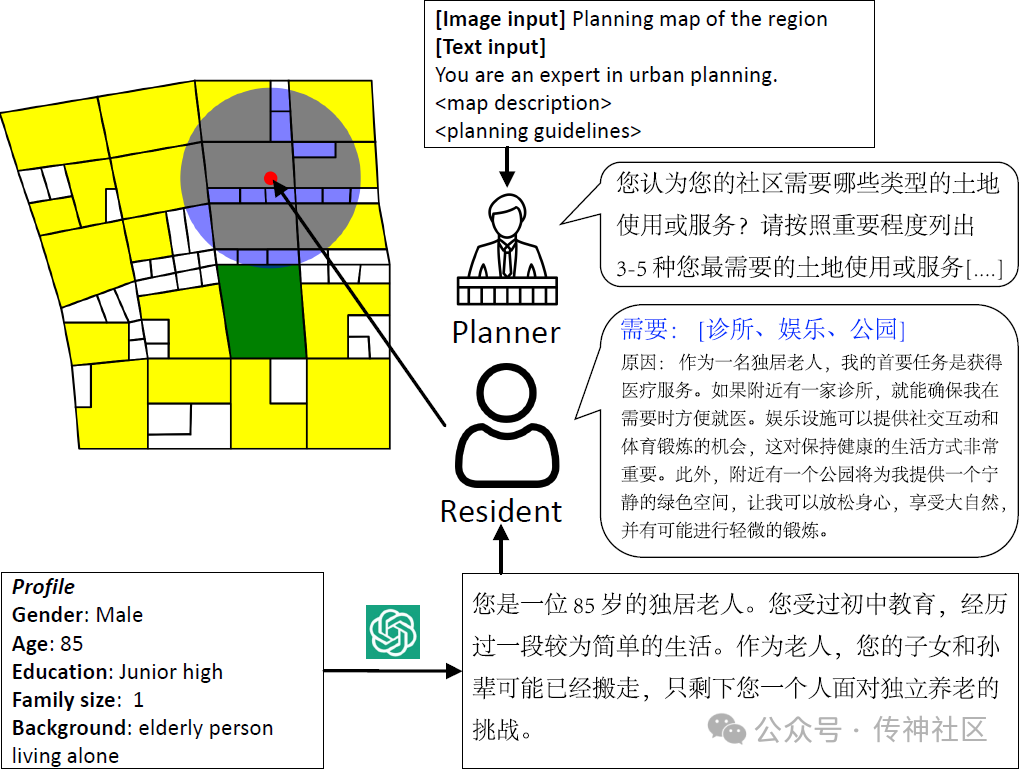

10 Large Language Model for Participatory Urban Planning

清华大学近期提出的研究,通过LLM技术实现了参与式城市规划的创新,不仅提高了规划的效率和居民满意度,还优化了生态和服务可达性指标。这一方法的成功应用于北京的案例展示了其前瞻性和实用价值。推荐给对城市规划、人工智能应用感兴趣的读者,特别是那些寻求将先进技术与社会需求结合的研究人员和从业者。

论文推荐链接:

https://portal.opencsg.com/daily_papers/EK61gmhmZqmA

投稿有礼

非常感谢您对传神社区的支持与认可,传神社区专注于打造中国本土化的huggingface plus,目前传神社区展开了征稿活动,主要聚焦开源技术、最新的科技动态、AGI产业应用的落地,我们诚挚的邀请您投稿,一旦投稿成功,我们传神小助手将会与您联系您并发放我们准备的礼品。

投稿方式:[email protected]

欢迎扫描下方二维码添加传神小助手微信。

“ 关于OpenCSG

关注OpenCSG

加入传神社区

ai论文查重

ai论文查重